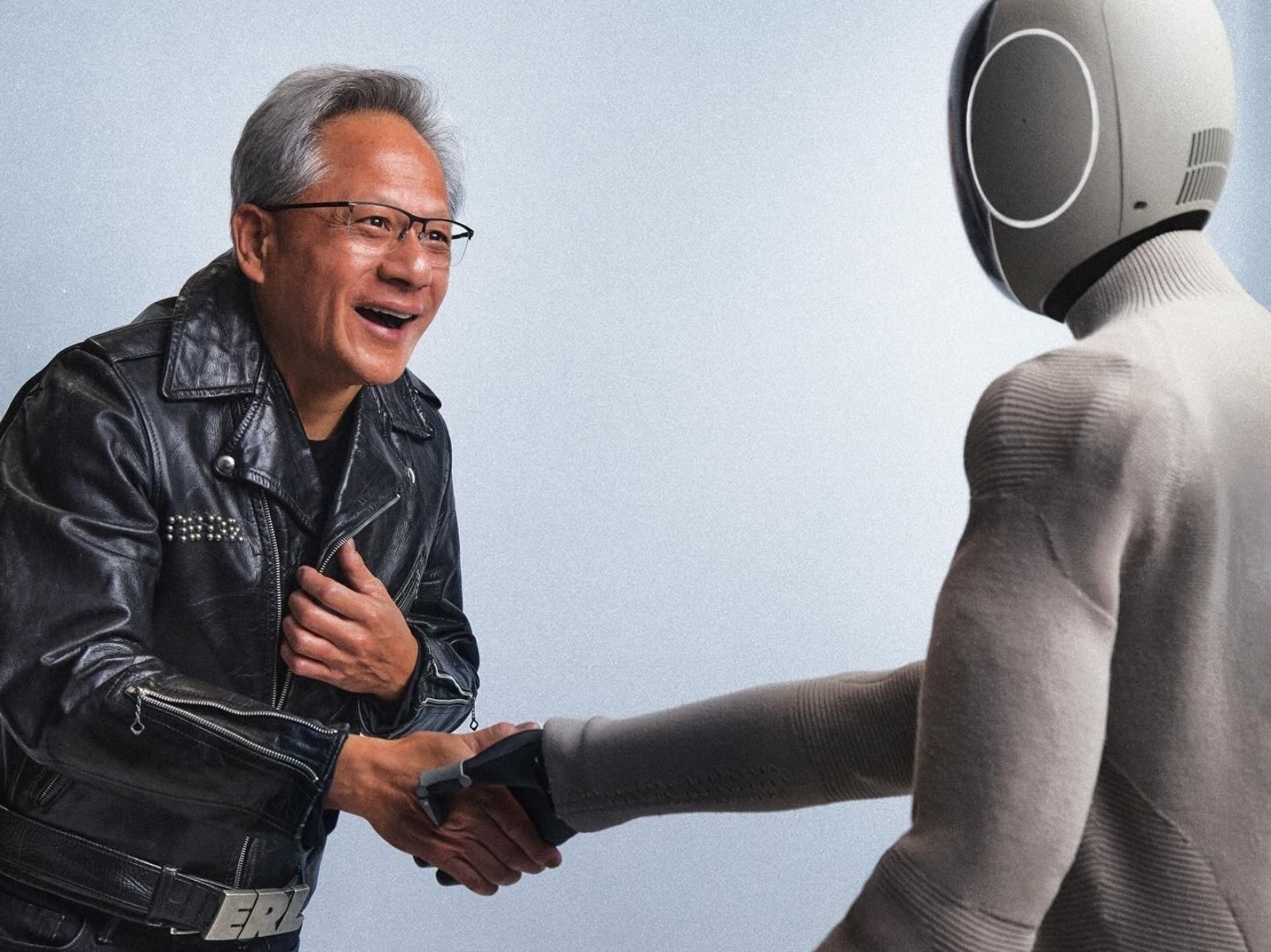

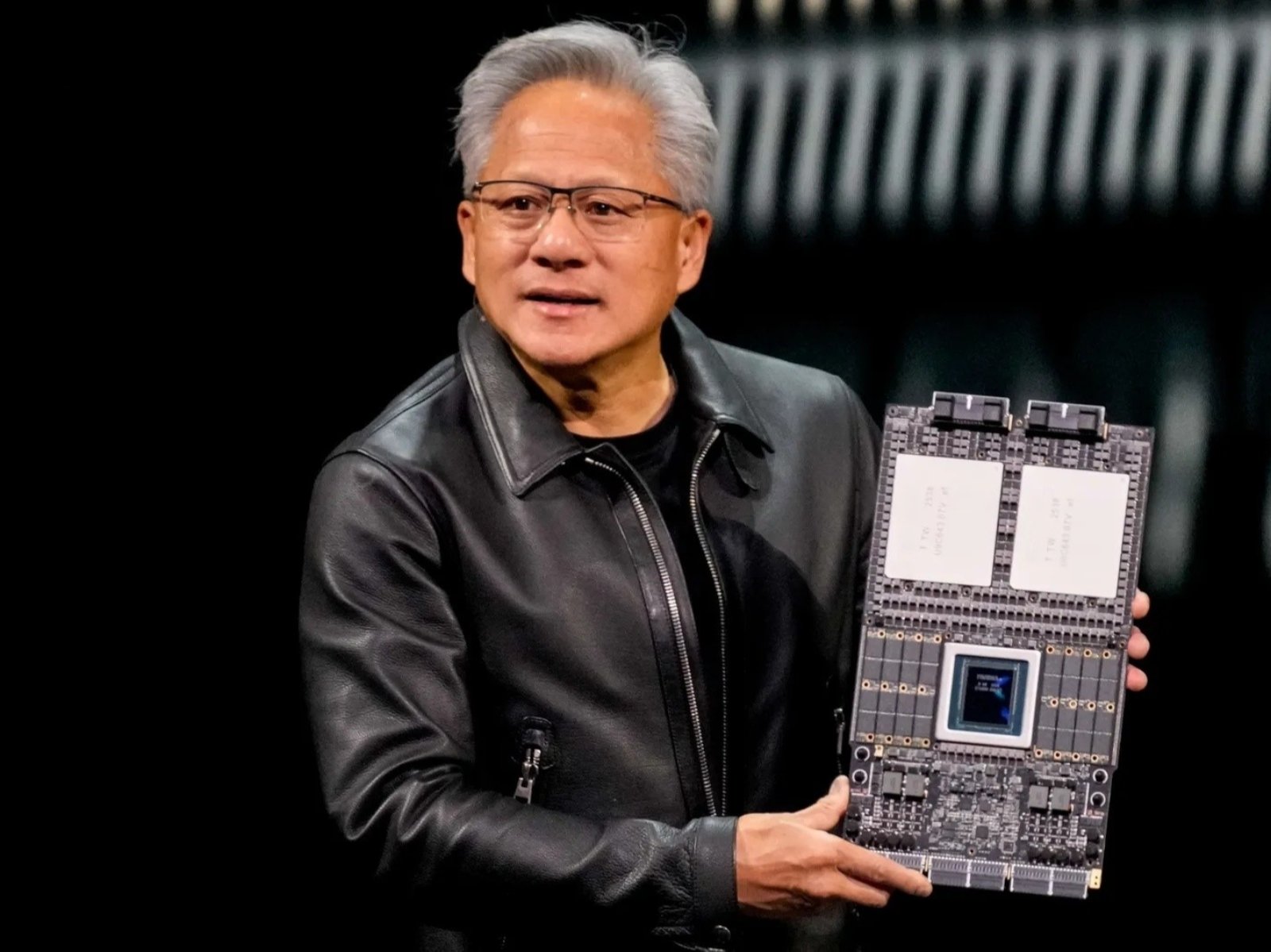

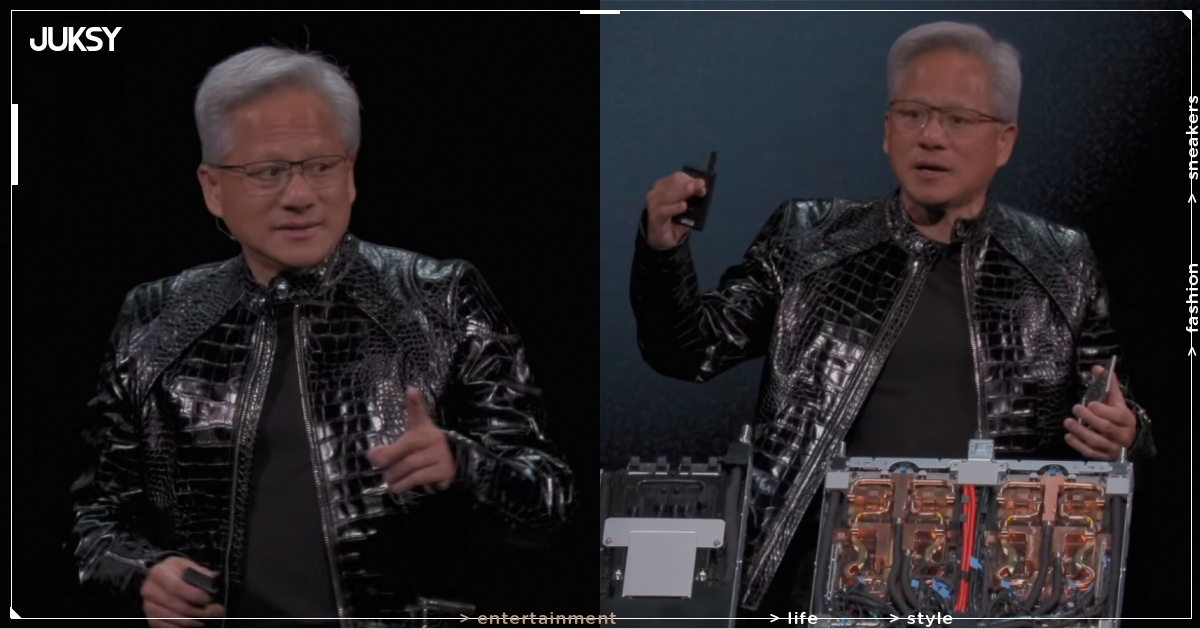

2026 年全球消費電子展(CES)正式登場,輝達(NVIDIA)執行長黃仁勳(Jensen Huang)身穿招牌皮衣現身主題演講,宣告 AI 產業正式邁入「實體 AI」與「推理時代」他在演講中揭露新一代 Vera Rubin 平台已全面投入生產,預計今年下半年正式上市,並強調這款晶片將成為業界首款整合 HBM4 高頻寬記憶體的處理器,黃仁勳指出,隨著開源推理模型崛起,AI 擴散速度前所未見,產業關鍵已從「模型能不能做」轉向「能不能長時間、低成本地運行」而 Rubin 平台正是為此量身打造的解決方案。

延伸閱讀:黃仁勳預言未來 90% 人類知識將由 AI 創造!但 AI 成為地球主宰者機率極低

黃仁勳 CES 演講會曝光輝達 Rubin 晶片全面量產!

Vera Rubin 平台採用極致協同設計,整合 6 款晶片,包含 GPU、CPU、NVLink 交換器、乙太網路交換器、智慧網卡與 DPU,根據官方數據,相較前一代 Blackwell 架構,Rubin 在推理方面的浮點效能提高 5 倍,訓練效能提高 3.5 倍,記憶體頻寬更提升 2.8 倍,最引人注目的是,Rubin GPU 搭載的 HBM4 記憶體頻寬達每秒 22TB,遠超 Blackwell 的 8TB/s,使單一 GPU 能同時處理更多推理任務並支援更長的上下文記憶,每個 Rubin GPU 整合 8 個 HBM4 堆棧,總容量達 288GB,配合 NVLink 6 互聯技術實現 3.6TB/s 的 GPU 間通訊頻寬,旗艦級伺服器 NVL72 搭載 72 個 Rubin GPU 與 36 個全新 Vera CPU,總記憶體頻寬達 1.6PB/s,較 Blackwell 平台提升近兩倍,實際應用中,這種提升使 AI 推理成本最高降低 10 倍,訓練混合專家模型的 GPU 需求減少至四分之一。

除了硬體升級,輝達同步推出由 BlueField-4 驅動的推理上下文記憶體儲存平台,在 GPU 記憶體與傳統儲存之間建立高速「第三層記憶體」可在特定場景下提升 token 處理量最高達 5 倍,黃仁勳強調,這套系統以「推理時擴展」為核心概念,AI 能力不再僅依賴訓練期擴模,而是透過推理階段投入更多算力與時間,換取顯著品質提升,此外輝達也發表 Cosmos Reason 2 模型,這款視覺語言模型旨在賦予機器人「實體推理」能力,讓 AI 代理能理解物理世界、規劃行動並處理複雜任務,在自動駕駛領域,輝達揭曉 Alpamayo 平台,號稱全球首款具備「思考與推理能力」的自動駕駛 AI 大腦,首款導入車款將由賓士 CLA 打頭陣,預計第一季在美國市場亮相,產業分析指出,HBM4 的部署時機恰逢 AI 運算需求爆發期,輝達提前量產 Rubin 系列反映市場對高效能記憶體解決方案的迫切需求,微軟 Azure 和 CoreWeave 等雲端服務商將於今年下半年首批提供基於 Rubin 的雲端運算執行個體,台廠方面,廣達、鴻海等供應鏈伙伴悄然入列自駕車 Tier 1 名單,顯示輝達正透過將運算、網路與儲存緊密綁定,試圖解決 AI 代理在處理複雜任務時可能遇到的效能瓶頸,並將 AI 從雲端推向真實世界的實體場域。

本站圖片部分取自於網路,如有版權使用疑慮煩請告知。

-

全球市值最高的晶片大廠 NVIDIA 週一宣布,以每股 87.20 美元的價格向雲端服務供應商 CoreWeave 追加投資 20 億美元,這筆資金將用於加速 AI 基礎設施建設,目標在 2030 年前建立超過 5 百萬瓩(GW)容量的 A ...2026-01-27

-

創下「日均翻桌 15 輪、候位 5 小時」等排隊盛況,甚至連「AI 教父」黃仁勳都登門用餐的成都最強麻辣鍋「馮校長老火鍋」即將於 2026年 1 月 3 日起正式登台。全台首店進駐人來人往的台北東區商圈,將最正統的「經典大紅鍋」湯底原汁原味 ...2025-12-23 更新

-

輝達(NVIDIA)執行長黃仁勳近期在接受知名 Podcast 主持人羅根(Joe Rogan)訪談時,針對全球日益升溫的「AI 終結者恐懼論」提出明確看法。他表示,人工智慧未來將主導人類知識的生成,預估未來兩三年內,全世界高達 90 %的 ...2025-12-08 更新

-

輝達(NVIDIA)執行長黃仁勳趁著美國感恩節假期,於11月27日無預警搭乘私人飛機旋風訪台,展開快閃2天1夜的行程。這位AI教父的一舉一動都受到高度關注,從抵台第一天到花娘小館用餐、拜訪台積電創辦人張忠謀,再到四平街購買蜜餞引起騷動,晚間 ...2025-11-30 更新

-

科技圈爆出震撼彈!美國科技新聞網站 The Information 報導指出,社群媒體巨擘 Meta 正與 Google(谷歌)接洽,計劃從 2027 年起在自家資料中心採用 Google 自研的 TPU(張量處理單元)人工智慧晶片,並可能 ...2025-11-26 更新

-

想像一下這樣的畫面:你早上出門前,客廳裡有個白灰色的人形機器人,正在幫你摺衣服、收拾沙發上的外套,還會在你出門時幫忙關門。這不是科幻電影的情節,而是挪威與美國混血機器人公司 1X Technologies 最新發表的家用人形機器人──NEO ...2025-11-05 更新

-

在宣布與 Nokia 展開合作的消息後,我們的爸爸「黃仁勳」又再次成為全球焦點。這不只是晶片巨頭的下一步,更像是為未來「網路+AI」格局下的一場硬體革命揭開序幕。「而且,這一切發生得非常快速。」黃仁勳在記者會上笑著說。的確,NVIDIA 宣 ...2025-10-30 更新

-

BTS 隊長 RM(金南俊)再創歷史紀錄!他受邀於 10 月 29 日登上「APEC 企業領袖高峰會」發表主題演講,成為首位登上 APEC 國際舞台的 K-POP 藝人。講者名單中,他與 AI 教父黃仁勳、亞馬遜雲端執行長賈曼及 Googl ...2025-10-29 更新

-

北市東湖的喜相逢麵館,可是黃仁勳等科技大佬的心頭好,還被封為「全台北最難訂的私廚餐廳」!不過最近卻傳出這家傳奇名店即將在十月底熄燈,準備進駐百貨美食街,消息一出立刻掀起熱議。有人笑說:「搬到美食街,還能保持原本的神祕感跟高端氛圍嗎?」 ...2025-09-08 更新

-

輝達執行長黃仁勳本週出席中國鏈博會引發轟動,不僅帶來 H20 晶片解禁的好消息,更以招牌皮衣和特別換上的唐裝搶盡風頭。期間他公開自己使用 Google Pixel 手機,看重其純淨 Android 系統,而非主流的蘋果或三星產品。值得注意的 ...2025-07-18 更新